Contributions aux Cartes Combinatoires et Cartes Généralisées : |

Soutenue publiquement le 23 Septembre 2010 devant le Jury composé de :

| M. Jean-Marc Chassery, Directeur de Recherches, CNRS, GIPSA-Lab | Rapporteur |

| M. Pedro Real, Professeur, Univ. de Seville, Dpt. Math. Appli. | Rapporteur |

| Mme Monique Teillaud, Chargé de Recherches HDR, INRIA, Sophia-Antipolis | Rapporteur |

| M. Luc Brun, Professeur, ENSICAEN, GREYC | Examinateur |

| M. Jean-Michel Jolion, Professeur, INSA de Lyon, LIRIS | Examinateur |

| M. Pascal Lienhardt, Professeur, Univ. Poitiers, XLIM-SIC | Examinateur |

| M. Bernard Péroche, Professeur, Univ. Lyon 1, LIRIS | Examinateur |

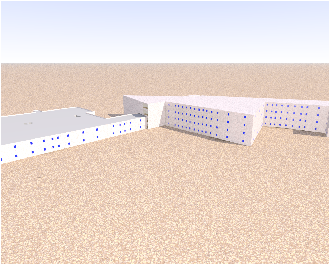

La problématique centrale de nos travaux est la représentation et la manipulation d’objets géométriques. Cette problématique se pose dans de très nombreux domaines, comme en modélisation géométrique, en traitement d’images, en rendu réaliste, en simulation d’écoulement de fluides…Dans chacun de ces cas, il est nécessaire d’avoir une structure de données décrivant les objets à manipuler et contenant suffisamment d’information pour les algorithmes utilisés. Cependant, ces informations ne doivent pas être en nombre trop important afin d’être capable de traiter un grand nombre d’objets. Le problème peut donc se résumer, comme souvent en informatique, à trouver le meilleur compromis entre espace mémoire et temps d’exécution des opérations. Mais un troisième problème important se pose dans notre cadre, qui est le pouvoir de modélisation de la structure de données. Ce problème est lié aux informations contenues dans celle-ci. En effet, il faut préciser ce qui est sous-entendu par représenter les objets et les informations, car de nombreuses solutions existent. Les questions auxquelles il va falloir répondre portent sur le type d’objets à représenter et le type de relations entre ces objets. Le choix de la «meilleure» structure de données va en effet dépendre de la dimension, de l’éventuelle régularité des objets, des possibilités pour les objets de se superposer, se toucher par un sommet ou une face…Selon les réponses à ces questions, le choix de la structure de données ne sera pas la même. Enfin, ce choix doit être également guidé par les algorithmes qui vont être utilisés par la suite. Si ces objets doivent uniquement être visualisés, et si nous disposons d’une carte graphique capable d’afficher uniquement des triangles, la meilleure structure de données sera sûrement une simple liste de triangles.

Il existe toute une gamme de structures de données qui ont été définies pour représenter des objets triangulés (triangles en 2D, tétraèdres en 3D, appelés simplexes en nD). Ces éléments de base sont mis en relations par des opérateurs qui vont décrire les relations d’adjacence et d’incidence. Ce type de structure a pour avantage principal d’être simple à mettre en œuvre, de pouvoir être défini en dimension quelconque, et enfin d’être directement utilisable dans des algorithmes de visualisation rapides. En effet, la plupart des moteurs de rendu actuels utilisent des triangles comme primitives de base. De plus, ce type de structure de données peut être mis en relation avec les objets simpliciaux définis en topologie algébrique, et il est alors possible de faire un lien direct entre la structure de données et une partie d’un espace topologique. L’inconvénient principal de ce type de structure se pose lors d’opérations de modification. En effet, certaines opérations produisent des objets non triangulés. Un autre inconvénient est qu’il faut un nombre important de simplexes pour décrire les objets.

Afin de résoudre ces problèmes, plusieurs structures de données ont été définies afin de pouvoir représenter les objets comme assemblage de n’importe quel type de cellules (et pas seulement des triangles). Parmi ces structures, les seules à avoir été formellement définies en dimension quelconque sont des structures proche de la notion de cartes. Ces structures de données ont plusieurs avantages qui justifient leur étude et leur utilisation. Elles sont définies en dimension quelconque à partir d’un seul élément de base. Le fait de ne pas avoir plusieurs structures de données liées entre elles simplifie les algorithmes, les mises à jour, et les développements informatiques. Une carte représente des objets subdivisés en cellules, et décrit toutes les relations d’adjacence et d’incidence entre ces cellules. De ce fait, il est très simple d’associer des informations à n’importe quelle cellule de la subdivision. De plus, l’accès aux différentes relations d’incidence et d’adjacence entre les cellules se fait en temps polynomial en le nombre de cellules dans le voisinage, ce qui donne des algorithmes efficaces. Enfin, le domaine des cartes est clairement défini et le lien formel entre les cartes et les modèles simpliciaux autorise le transfert aux cartes des nombreux travaux existant en topologie algébrique. Pour cette raison, les cartes ne sont pas seulement une structure de données mais bien un modèle mathématique de représentation des objets. De plus, des contraintes de cohérence précises existent et permettent de tester simplement la validité d’une carte.

Ces modèles sont relativement jeunes puisqu’ils ont pris leur essor au début des années 1990, et ils souffrent de ce fait d’un manque de reconnaissance et d’utilisation. De plus, les papiers de références sont très complets, mais du coup également peu abordables pour une personne non initiée, ce qui est une deuxième cause limitant leur utilisation.

Dans ce cadre, nos travaux ont débuté en 1998 tout d’abord dans l’optique d’utiliser les cartes combinatoires afin de décrire les partitions d’images 3D. Nous nous sommes très vite rendu compte qu’il existait un fossé entre les travaux menés en traitement et analyse d’images, et ceux menés en modélisation géométrique. Ce fossé s’expliquait par la manière dont les deux communautés s’étaient intéressées aux cartes : en modélisation, l’objectif est de manipuler et représenter des objets, principalement en 3D, et de définir des opérations de transformation ; en imagerie, les cartes étaient principalement vues comme une extension des graphes planaires représentant l’ordre des arêtes autour des sommets. De ce fait, les habitudes étaient de transposer les algorithmes sur les graphes en algorithmes sur les cartes, ce qui fonctionnait très bien en 2D, mais rendait difficile le passage en dimension supérieure. Après nous être rendu compte de ce problème, nous avons depuis lors essayé de mener de front des activités de modélisation géométrique et de traitement d’images afin que chaque domaine profite des résultats de l’autre, mais également pour que les deux domaines contribuent à de nouvelles avancées autour des cartes.

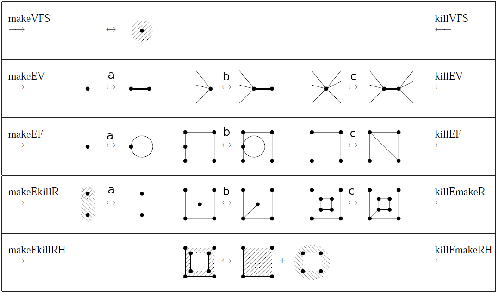

C’est ce type de réflexion qui nous pousse encore aujourd’hui à réfléchir aux opérations en termes les plus génériques possibles, en dimension quelconque, et sans fixer de contraintes liées à un cadre d’application. C’est dans ce cadre que nous avons défini des opérations de base qui sont les suppressions, contractions, insertions et éclatements. Nous montrons dans ce mémoire que ces opérations peuvent être vues comme une généralisation des opérateurs d’Euler.

Ces opérations sont au cœur de nos travaux et sont le fil conducteur de ce mémoire. En effet, nous avons eu très tôt l’idée de simplifier progressivement un objet à partir d’une carte de base, et d’une application d’une suite de simplifications, en les contrôlant afin de préserver certaines propriétés. Nous avons utilisé ce principe de simplification dans plusieurs problématiques très différentes abordées dans ce mémoire, qui vont de la définition des cartes topologiques, au calcul des groupes d’homologie, en passant par la segmentation d’images ou par des algorithmes de reconstruction de contour discrets.

Mais il n’est pas toujours possible de définir les modèles et opérations de manière générique en nD. En effet, il peut exister des contraintes d’efficacité et nous avons alors besoin d’optimiser un cas particulier par exemple pour des raisons d’espace mémoire. Il existe également des spécificités selon les dimensions. Par exemple en 2D, il est possible d’utiliser le théorème de classification des surfaces afin de définir un algorithme de caractérisation, alors que ce type de théorème n’existe pas en dimension supérieure. Une dernière raison pouvant limiter une définition générique peut tout simplement être la difficulté du passage en dimension supérieure qui fait que nous commençons par étudier les choses en 2D, puis 3D avant d’essayer de généraliser en dimension n.

C’est dans ce cadre que nous avons défini la carte topologique 3D, qui était le sujet initial de notre thèse [Dam01]. Afin d’arriver à cette définition, nous sommes reparti de la dimension 2, en nous reposant les questions de base sur les raisons d’être des modèles existants. Ce type de questionnement nous a amené à proposer la notion de niveau de simplification, qui utilise les opérations de suppression, et c’est cette notion qui nous a permis ensuite de définir de manière relativement simple les cartes topologiques en 3D alors que cela était beaucoup plus difficile de manière directe. Nous avons depuis beaucoup travaillé autour de ces cartes topologiques, en 2D et 3D, afin de définir des opérations de manipulation, comme la fusion ou la découpe de régions, qui nous ont servi ensuite à définir des opérations de segmentation d’images.

Nous avons également étudié différents liens entre les cartes et les invariants topologiques. En effet, il existait très peu de travaux sur le calcul d’invariants topologiques pour les cartes, et aucun ne permettant la mise à jour de ces invariants dans le cadre des opérations de simplification. Nous avons tout d’abord proposé une méthode de calcul de la caractéristique d’Euler-Poincaré, en nous appuyant à nouveau sur l’étude des opérations de base et sur leur impact sur l’évolution des nombres de cellules. Nous avons alors ensuite cherché à calculer d’autres invariants topologiques plus puissants. Cela nous a amené à étudier le calcul des nombres de Betti, puis des groupes d’homologie, pour le moment uniquement en 2D et 3D. Nous avons pu alors utiliser nos algorithmes de calcul des nombres de Betti au sein d’un critère de segmentation d’images 3D, ce qui nous a permis de définir une méthode de segmentation d’images avec contrôle topologique.

Au final, tout ces travaux vont dans la même direction : la définition d’outils performants, génériques, et topologiques de manipulation d’objets 2D, 3D ou nD. Ils ont été en partie réalisés au cours des thèses de Carine Simon, Sébastien Horna, Alexandre Dupas et Romain Goffe, que nous avons co-encadrés. D’autre par, ils ont été réalisés en collaboration avec d’autres chercheurs français: Olivier Alata, Sylvie Alayrangues, Eric Andres, Denis Arrivault, Mehdi Baba-ali, Fabien Baldacci, Yves Bertrand, Camille Bihoreau, Pascal Bourdon, Achille Braquelaire, Luc Brun, David Coeurjolly, Martine Dexet-Guiard, Jean-Philippe Domenger, Christophe Fiorio, Laurent Fuchs, Colin De La Higuera, Jean-Christophe Janodet, Jacques-Olivier Lachaud, Pascal Lienhardt, David Marcheix, Daniel Meneveaux, Christian Olivier, Samuel Peltier, Patrick Resch, Emilie Samuel, Xavier Skapin, Christine Solnon, Frédéric Vidil ; et étrangers : Yll Haxhimusa, Adian Ion, Walter G. Kropatsch. Enfin, une partie de ces problématiques ont été étudiées dans le cadre du projet ANR Fogrimmi de Janvier 2007 à Décembre 2010, dans lequel nous avons été porteur pour le laboratoire XLIM-SIC. Ces différents travaux montrent chacun, à différents niveaux, l’intérêt d’utiliser des cartes dans différentes problématiques, et nous espérons qu’ils participeront à promouvoir leur diffusion. Nous espérons également que ce mémoire œuvrera dans ce sens en regroupant en un même endroit les notions principales autour des cartes.

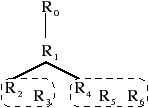

Le plan de ce mémoire est le suivant. Tout d’abord nous présentons au chapitre 2 les notions de base de la topologique algébrique, les modèles existants, puis nous présentons en détails les cartes combinatoires et les cartes généralisées. Ce chapitre est l’occasion d’éclaircir certains points, et de compléter des notions qui manquaient jusqu’alors. Le chapitre 3 présente les quatre opérations de base que nous avons définies en dimension quelconque dans le cadre des cartes généralisées : la suppression, son opération duale qui est la contraction, et les opérations inverses qui sont l’insertion et l’éclatement. Nous présentons également l’opération de décalage d’arête. Le chapitre 4 présente la carte topologique en 2 et 3 dimensions. C’est un modèle décrivant la partition d’une image en régions et qui est basé sur les cartes combinatoires. Sa définition utilise les opérations de base, qui sont contrôlées afin de garantir l’absence de perte d’information. Le chapitre 5 introduit les pyramides généralisées qui sont une extension hiérarchique des cartes généralisées, et donne les principales définitions utiles afin de retrouver les informations au sein de ce type de pyramide. Nous présentons au chapitre 6 des algorithmes de calcul d’invariants topologiques utilisant les cartes. Nous nous sommes intéressés à la caractéristique d’Euler-Poincaré, aux nombres de Betti, et aux groupes d’homologie. Le chapitre 7 illustre l’application de ces différents travaux dans quelques utilisations que nous avons pu faire. Pour le moment, nous avons principalement appliqué nos méthodes dans un projet de reconstruction de complexes architecturaux, et dans des algorithmes de segmentation d’images autorisant un contrôle topologique. Enfin, le chapitre 8 conclut ce mémoire et présente mon programme de recherche pour les années à venir.

La topologie algébrique (anciennement appelée topologie combinatoire) est une branche des mathématiques cherchant à étudier les espaces topologiques en leur associant un objet algébrique (groupe, espace vectoriel, …) dont les propriétés servent à déterminer un certain nombre d’invariants caractérisant la topologie de l’espace initial. Deux outils ont été beaucoup utilisés afin de réaliser cette étude : le groupe fondamental ou plus généralement la théorie de l’homotopie, et le groupe d’homologie ou groupe de co-homologie.

Le problème de la théorie de l’homotopie est que les groupes d’homotopie sont difficilement exploitables de manière simple. Une difficulté importante provient de la représentation de ces groupes qui est réalisée par un ensemble de mots et des relations sur ces mots. De ce fait, savoir si deux groupes sont isomorphes revient à résoudre le problème du mot1. Or, ce problème a été montré indécidable [Nov55] ce qui implique que le problème général de savoir si deux groupes fondamentaux sont isomorphes l’est également2. Pour s’affranchir de ce problème, nous nous intéressons donc ici à la théorie de l’homologie dans laquelle les représentations des groupes et les algorithmes de calcul peuvent être envisagés. Pour cette raison, nous n’étudions donc pas du tout par la suite le groupe fondamental mais uniquement les groupes d’homologie et les notions associées.

Dans nos travaux, nous nous intéressons aux partitions d’espaces en cellules comme les complexes simpliciaux ou les complexes cellulaires. Intuitivement, nous souhaitons représenter un sous-espace de ℝn de manière combinatoire c’est-à-dire en «oubliant» la forme. Il existe différentes manières de faire selon les propriétés des objets représentés (par exemple orientables ou non, simpliciaux ou cellulaires…), mais dans tous les cas, il est important de pouvoir contrôler la validité des objets représentés. C’est pour cette raison que la partie la plus importante dans la définition de modèles combinatoires concerne leurs contraintes de cohérence. Ce sont elles qui vont garantir que l’objet combinatoire correspond bien à son équivalent topologique. Elles peuvent également autoriser la vérification algorithmique qu’un objet donné est valide ou non. Dans ce cadre, nous nous sommes plus particulièrement aux cartes combinatoires et cartes généralisées, deux modèles permettant de représenter des partitions cellulaires nD, et autorisant un accès efficace aux cellules et aux relations entre celles-ci.

L’objectif de ce chapitre est de centraliser les principales notions autour des cartes combinatoires et généralisées. La plupart de ces notions sont issues des deux papiers de références [Lie91, Lie94] ainsi que du chapitre de livre [LFB07] ; les notions préliminaires sont souvent issues des livres [Spa66, Cro78, Mun84, Hat02] ; certains éléments proviennent de la lecture des thèses [Elt94, Lan95, Ala05, Pel06, Fav09, Dup09]. Certaines notions concernant le dual et les cartes ouvertes sont «re-découvertes» dans ce chapitre : soit car les notions originales ne correspondent pas exactement à celles utilisées ; soit car elles manquaient d’explications, d’illustrations ou de preuves. J’espère que ce chapitre pourra servir de référence pour un lecteur cherchant des explications précises sur les cartes, en regroupant en un même endroit les principales notions portant sur les cartes combinatoires et généralisées.

Ce chapitre est organisé de la manière suivante. Nous présentons Section 2.1 les notions de base de topologie algébrique, les notations utilisées dans ce mémoire, et quatre modèles topologiques classiques qui sont les complexes simpliciaux, les complexes cellulaires, les complexes simpliciaux abstraits et les complexes cellulaires abstraits. Nous introduisons Section 2.2 des structures combinatoires permettant de représenter ces modèles, ou certaines sous-classes, et décrivant directement les relations entre les éléments : les ensembles semi-simpliciaux qui sont une sous-classe des complexes simpliciaux ; les cartes combinatoires, en rappelant l’historique de leur définition en 2D, et les cartes généralisées, qui permettent de représenter des sous-classes de complexes cellulaires orientables pour les cartes combinatoires, et quelconques pour les cartes généralisées. Nous détaillons également les cartes combinatoires ouvertes, une extension des cartes pouvant représenter des complexes ouverts. La Section 2.3 détaille le lien entre les cartes et les ensembles semi-simpliciaux, ce qui permet de transposer des définitions basées sur les complexes simpliciaux vers les complexes cellulaires, comme par exemple le calcul de la caractéristique d’Euler-Poincaré.

Nous commençons par présenter quelques notions de base de topologie algébrique qui seront utiles dans la suite de ce mémoire.

Soit un ensemble E, une famille d’ensembles sur E (ou famille de sous-ensembles de E) est un ensemble de sous-ensembles de E. P(E) est l’ensemble des parties de E . C’est une famille d’ensembles sur E définie par P(E)={X ⊆ E}. Une partition P de E est une famille d’ensembles sur E telle que les éléments de P sont deux à deux disjoints et forment un recouvrement de E (cf. Def. 1).

Le couple (X,τ) est appelé espace topologique. Les éléments de X sont appelés les points, et les éléments de τ sont appelés les ouverts de la topologie. Un sous-ensemble de X est dit fermé si son complémentaire dans X est ouvert. Chaque élément de τ peut être ouvert, fermé, les deux à la fois, ou encore ni ouvert ni fermé. Par définition, ∅ et X sont toujours des ouverts et des fermés. Soit X un ensemble d’éléments, la topologie discrète sur X est la topologie (X,P(X)). De façon intuitive, c’est la topologie dans laquelle chaque point est «isolé». En effet, dans cette topologie, chaque point de X est à la fois ouvert et fermé. Une notion fondamentale en topologie est la notion de voisinage. Soit x ∈ X. V ⊆ X est un voisinage de x dans la topologie (X,τ) si il existe un ouvert inclus dans V contenant x. Le voisinage d’un point n’est jamais vide car X est un voisinage de tout point de X. Un espace topologique est dit séparé, ou espace de Hausdorff, si pour deux points distincts x et y quelconques, il existe un voisinage de x et un voisinage de y disjoints.

Bn est la boule unité nD : c’est l’ensemble des points x de ℝn tel que ||x|| ≤ 1 (avec si x=(x1,…,xn), ||x||=√x12+… xn2). La boule unité ouverte nD h(B)n est l’ensemble des points x de ℝn tel que ||x|| < 1. La demi-boule unité consiste à restreindre une coordonnée (la première dans ce qui suit) aux nombres positifs ou nuls. B1/2n = {x=(x1,…,xn) | ||x|| ≤ 1 et x1 ≥ 0}, et enfin la demi-boule unité ouverte3 est h(B1/2)n = {x=(x1,…,xn) | ||x|| < 1 et x1 > 0}. Sn−1 est la sphère unité nD : c’est l’ensemble des points x de ℝn tel que ||x|| = 1.

Par exemple Bn est une variété fermée, dont le bord est Sn−1, tandis que h(B)n est une variété ouverte, donc sans bord.

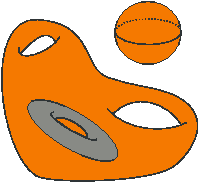

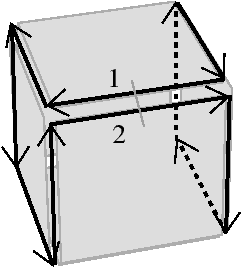

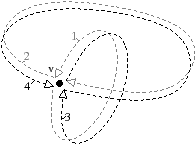

Une variété topologique nD est dite orientable s’il est possible de définir une direction «gauche» et «droite» globalement en tout point de la variété. Elle est dite non-orientable sinon. Deux exemples de 2-variétés non orientables sont présentés Fig. 2.1 : le ruban de Möbius à la Fig. 2.1.1, et la bouteille de Klein à la Fig. 2.1.1.

Après cette introduction aux notions topologiques de base, nous introduisons maintenant les notations et outils mathématiques que nous utilisons par la suite.

Soit E un ensemble non vide. Soit f une fonction de E dans E. f est une permutation sur E si c’est une bijection de E dans E. f est une involution sur E si c’est une bijection de E dans E telle que f=f−1, ce qui est équivalent à f ∘ f = IdE (une involution est donc une permutation particulière ; de ce fait, lorsque nous considérerons un ensemble de permutations, il pourra contenir des involutions). Soit e ∈ E, e est un point fixe de f si f(e)=e. Soit X ⊆ E, nous notons f(X)={f(x)|x ∈ X}. IdE est la fonction identité de E dans E .

Une relation d’ordre R pour un ensemble E est une relation binaire réflexive (x R x) transitive (x R y et y R z ⇒ x R z) et antisymétrique (x R y et y R x ⇒ x=y). Si pour tout couple d’éléments x,y dans E2, x et y sont comparables par R, la relation d’ordre est dite totale. Sinon elle est dite partielle.

Soit Φ={f1,…,fk} un ensemble de permutations sur un même ensemble E, et e ∈ E. Nous utilisons parfois la notation anglaise e f1 … fk pour fk(…(f1(e))). ⟨Φ⟩ est le groupe de permutations engendré par Φ. C’est l’ensemble des permutations qu’il est possible d’obtenir de Φ par application de la composition et de l’inverse. Ce groupe de permutations permet de définir la notion d’orbite d’un élément de E.

L’orbite d’un élément est l’ensemble des éléments de E qu’il est possible d’atteindre par application, à partir de e, de n’importe quelle suite de fi et fi−1. Étant donnée un ensemble de permutations Φ, nous notons z(⟨Φ⟩) le nombre d’orbites distinctes d’éléments de E, c’est-à-dire |{⟨Φ⟩(e)|e∈ E}| (cf. Section 2.2.3 pour des exemples d’orbites).

Un complexe simplicial [Spa66, Ago76, PBCF93, Hat02] peut être vu de manière constructive comme un espace topologique obtenu en collant entre eux des simplexes.

Un simplexe s de dimension n est un n-polyèdre5 formé par l’enveloppe convexe d’un ensemble P de n+1 points de ℝn affinement indépendants. Un sommet est un 0-simplexe, un segment un 1-simplexe, un triangle un 2-simplexe et un tétraèdre un 3-simplexe. Un n-simplexe est homéomorphe à la boule Bn. L’enveloppe convexe de n’importe quel sous-ensemble non vide de P est une face de s (donc une face est elle-même un simplexe). Un simplexe f est une coface de s si s est une face de f. Deux simplexes sont incidents si l’un est une face de l’autre, et deux i-simplexes s1 et s2 sont adjacents s’il existe un simplexe qui soit une face de s1 et une face de s2.

Par définition des simplexes comme enveloppe convexe de points affinement indépendants, un simplexe a nécessairement une géométrie linéaire (c-à-d chaque 1-simplexe est un segment de droite), et ne peut pas avoir de dégénérescence6. De plus, la définition d’un complexe simplicial interdit la présence de multi-incidence (c-à-d le cas de deux i-simplexes ayant pour intersection plus d’un simplexe. En effet, dans ce cas, l’intersection n’est pas une face des deux simplexes).

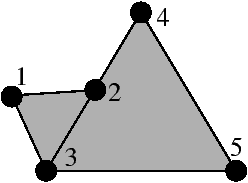

La Fig. 2.2 montre un exemple et un contre-exemple de complexe simplicial. Pour la Fig. 2.1.2, le complexe est composée de cinq sommets numérotés de 1 à 5, de six 1-simplexes et de deux 2-simplexes (donc le complexe contient en tout 13 simplexes). Il est facile de vérifier sur cet exemple que l’intersection de n’importe quel couple de simplexes est un simplexe ou est vide. Par contre, l’ensemble présenté Fig. 2.1.2 n’est pas un complexe simplicial car l’intersection des deux triangles n’est pas une face commune.

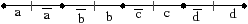

[a][b]

Figure 2.2: Un exemple (a) et un contre-exemple (b) de complexe simplicial. (a) L’ensemble contenant les deux 2-simplexes de sommets {a,b,c} et {a,b,d}, le 1-simplexe de sommets {b,e}, et toutes leurs faces est un complexe simplicial contenant cinq sommets, six 1-simplexes et deux 2-simplexes. (b) L’ensemble contenant les deux 2-simplexes et toutes leurs faces n’est pas un complexe simplicial car l’intersection des deux 2-simplexes de sommets {1,2,3} et {3,4,5} est l’arête de sommets {2,3} qui n’est pas une face du simplexe de sommets {3,4,5}.

La Def. 10 de pseudo-variétés7 permet de vérifier de manière combinatoire si un complexe simplicial représente une variété [Sti80].

Mais cette notion de pseudo-variété n’est pas équivalente à la notion de variété. Considérons l’exemple de la Fig. 2.3. C’est un ensemble de triangles formant une surface homémorphe à la sphère S2, dans lequel deux sommets de la surface sont identifiés. Ce complexe simplicial est une pseudo-variété (car chaque 1-simplexe est bien la face d’au plus deux 2-simplexes), mais n’est pas une variété car le voisinage du point résultat de l’identification n’est pas homéomorphe à la boule ouverte h(B2) ni à la demi-boule ouverte h(B1/2)2.

Les complexes simpliciaux ont été étendus pour pouvoir utiliser des éléments de base plus généraux que les simplexes : ce sont les CW-complexes (appelés parfois complexes cellulaires) défini par [Whi49]. Il existe de nombreux travaux autour des CW-complexes et leur étude sort du cadre de ce travail. Nous introduisons simplement ici les notions intuitives. De manière informelle, un CW-complexe est obtenu en collant entre elles des cellules de base qui sont homéomorphes à des boules Bn, de telle sorte que le collage respecte des propriétés de continuité. Plus précisément, un CW-complexe est un espace de Hausdorff X, avec une décomposition de X en cellules, et une fonction continue entre chaque n-cellule et Bn qui doit vérifier des propriétés supplémentaires. Il faut noter que cette définition des CW-complexes rend difficile la mise en œuvre de structure de données pour les manipuler de par la présence de la fonction continue et de ses propriétés. La Def. 10 de pseudo-variété est étendue au CW-complexes en remplaçant les simplexes par des cellules.

Un complexe simplicial abstrait (CSA) correspond à l’information purement combinatoire qu’il est possible d’extraire d’un complexe simplicial.

Chaque élément A de K est un simplexe. Un sous-ensemble de A étant une face de A, cette définition peut se reformuler en disant que chaque face de chaque simplexe appartient au complexe. La dimension d’une face A est |A|−1. La dimension du complexe est la plus grande dimension d’un simplexe de K. Un simplexe est dit principal s’il n’est la face d’aucun simplexe du complexe.

À tout complexe simplicial abstrait peut être associé un complexe simplicial. Ce complexe simplicial est appelée la réalisation géométrique du complexe simplicial abstrait. Il faut noter que cette réalisation géométrique est unique à isomorphisme près. Lors de l’association de la géométrie à un complexe simplicial abstrait, il faut vérifier que les contraintes géométriques du complexe simplicial sont satisfaites. De manière réciproque, à chaque complexe simplicial peut être associé un complexe simplicial abstrait. Il suffit d’énumérer tous les simplexes par leurs ensembles de sommets pour construire le complexe simplicial abstrait correspondant.

Prenons comme exemple le complexe simplicial abstrait {{a,b,c},{a,b,d},{b,e}, {a,b},{a,c},{b,c},{a,d},{b,d},{a},{b},{c},{d},{e}}. Les trois premiers éléments de cet ensemble sont les simplexes principaux. L’ensemble des sommets est {a,b,c,d,e}. {a,b} est une face de dimension 1 de {a,b,c}, et la dimension du complexe est 2. Le complexe simplicial de la Fig. 2.1.2 est une réalisation géométrique de ce complexe simplicial abstrait.

Considérons maintenant le CSA {{a,b,c},{c,d,e},{a,b},{a,c},{b,c},{c,d},{d,e},{c, e},{a},{b},{c},{d},{e}}. Il est possible d’associer aux sommets a,b,c,d,e de ce CSA les sommets 1,2,3,4,5 de la Fig. 2.1.2 (dans l’ordre). Avec cette association, chaque simplexe du CSA correspond à un simplexe du complexe simplicial. Mais ce n’est pas une réalisation géométrique de ce CSA car dans ce cas les contraintes géométriques du complexe simplicial ne sont pas vérifiées. La Fig. 2.4 montre un complexe simplicial qui est la réalisation géométrique de ce CSA.

Figure 2.4: Un complexe simplicial qui est la réalisation géométrique du complexe simplicial abstrait {{a,b,c},{c,d,e},{a,b},{a,c},{b,c},{c,d},{d,e},{c,e},{a},{b},{c},{d}, {e}}.

Les complexes cellulaires abstraits [Mun84, Kle00, KR04, Kov08] étendent les complexes simpliciaux abstraits pour ne plus considérer uniquement des simplexes mais des cellules quelconques. Par rapport aux complexes simpliciaux abstraits, il faut désormais ajouter la notion de dimension qui était avant implicite de par la nature régulière des simplexes, et expliciter la relation de face entre les cellules.

Les éléments de C sont les cellules du complexe, et la relation ≼ est la relation de face. Les faces d’une cellule c sont toutes les cellules c′ tel que c′ ≼ c. Cette relation permet de définir la notion d’incidence et d’adjacence. Deux cellules sont incidentes si l’une est la face de l’autre, et deux cellules c et c′ sont adjacentes si dim(c)=dim(c′) et ∃ f ∈ C, tel que f est une face de c et une face de c′.

De manière similaire aux complexes simpliciaux abstraits, la dimension d’un complexe cellulaire abstrait C est la plus grande dimension d’une cellule de C, et une cellule est dite principale si elle n’est la face d’aucune cellule du complexe.

Un invariant topologique est une propriété qui se conserve par homéomorphisme : les invariants topologiques de deux objets homéomorphes sont égaux. La dimension de l’objet ou son nombre de composantes connexes sont deux exemples d’invariants topologiques.

La caractéristique d’Euler-Poincaré est le plus connu des invariants topologiques. Pour un complexe cellulaire, elle se définit simplement par la somme alternée du nombre de cellules de chaque dimension (cf. Def. 13). Comme cette caractéristique est un invariant topologique, elle ne dépend pas de la décomposition cellulaire. De plus, elle est réunion-additive, c’est-à-dire que la caractéristique d’Euler-Poincaré d’un objet qui est l’union disjointe de deux objets est la somme des deux caractéristiques de ces objets.

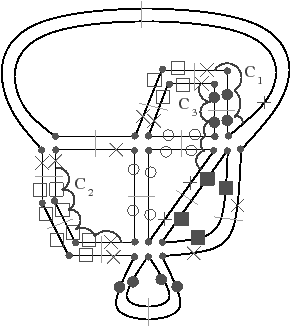

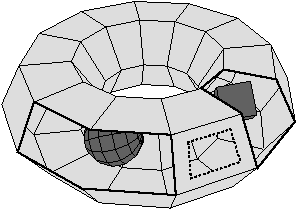

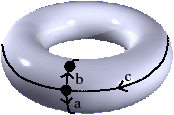

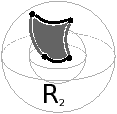

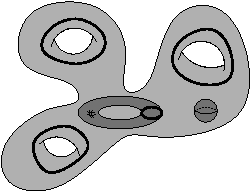

Nous présentons Fig. 2.5 un exemple de calcul de la caractéristique d’Euler-Poincaré pour deux subdivisions différentes d’un tore. Dans le premier cas, le complexe cellulaire est composé de neuf 0-cellules, dix-huit 1-cellules et neuf 2-cellules. χ=9−18+9=0. Dans le second cas, le complexe cellulaire est composé de seize 0-cellules, trente-deux 1-cellules et seize 2-cellules. χ est donc à nouveau égale à 0.

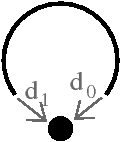

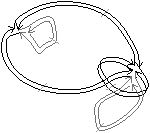

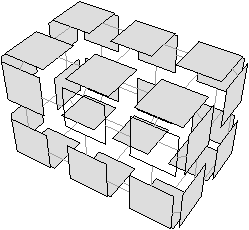

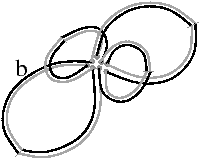

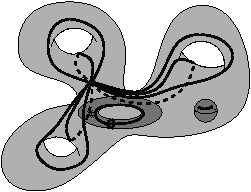

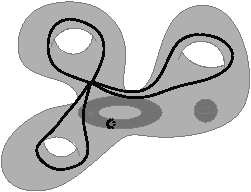

Les nombres de Betti (notés bi pour le nombre de Betti en dimension i) sont des invariants topologiques qui, intuitivement, comptent le nombre de «trous» dans chaque dimension. Par exemple, pour un objet 3D, b0 compte le nombre de composantes connexes, b1 compte le nombre de tunnels (appelés parfois anses) et b2 compte le nombre de cavités (appelées parfois trous). Pour un objet nD, les nombres de Betti bk pour k>n sont tous égaux à zéro. Pour l’exemple de la Fig. 2.1.4, b0=1, b1=3 et b2=2, et pour celui de la Fig. 2.1.4, b0=2, b1=3 et b2=1.

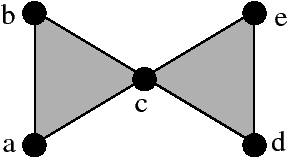

[a][b]

Figure 2.6: Nombres de Betti en dimension 3. Les objets représentés ici sont «pleins». (a) Complexe cellulaire 3D composé d’une composante connexe : b0=1 ; de trois tunnels : b1=3 ; et de deux cavités: b2=2 : χ=1. (b) Complexe cellulaire 3D composé de deux composantes connexes : b0=2 ; de trois tunnels : b1=3 ; et d’une cavité : b2=1 : χ=1.

La caractéristique d’Euler-Poincaré peut également être définie comme la somme alternée des nombres de Betti (Def. 14), et les deux définitions sont équivalentes (cf. [Hat02]).

Par cette définition, deux complexes cellulaires ayant mêmes nombres de Betti ont la même caractéristique d’Euler-Poincaré. Mais l’inverse n’est pas vrai : deux complexes ayant la même caractéristique d’Euler-Poincaré n’auront pas forcément les mêmes nombres de Betti comme nous pouvons le voir sur l’exemple de la Fig. 2.6. De ce fait, les nombres de Betti sont des invariants topologiques «plus puissants» que la caractéristique d’Euler-Poincaré car ils permettent de différencier plus de complexes cellulaires que la caractéristique d’Euler-Poincaré.

Les nombres de Betti sont liés aux groupes d’homologie, un autre invariant topologique. Plus précisément, le nombre de Betti bi est le rang du ième groupe d’homologie. Cet invariant est encore plus puissant que les nombres de Betti car il décrit les trous des objets en terme de cycles de cellules et pas uniquement en les comptant. De ce fait, il représente les torsions de l’objet (les parties d’un objet non orientable qui ont été recollées «à l’envers») qui ne sont pas prises en compte dans les nombres de Betti. Par contre la caractéristique d’Euler-Poincaré et les nombres de Betti sont plus simples à manipuler car ils sont définis directement comme des valeurs numériques.

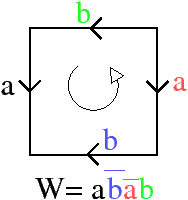

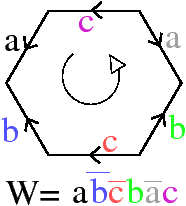

En 2D, le Théorème 1 de classification des surfaces (qui date des années 1860, mais qui est donné par exemple dans [Lee00]) prouve que toute surface peut se caractériser par son orientation et sa caractéristique d’Euler-Poincaré.

La somme connexe de deux surfaces M et N, notée M#N, est obtenue en enlevant un disque (homéomorphe à B2) de chacune des deux surfaces, et en recollant les deux surfaces le long des deux bords créés. La caractéristique d’Euler-Poincaré de la somme connexe est calculée à partir de la somme des caractéristiques de chaque surface moins les deux disques : χ(M#N)=χ(M)+χ(N)−2.

Les deux premières familles du théorème de classification sont les surfaces orientables. Dans ces deux cas, le nombre g, appelé le genre, est le nombre de tores utilisés dans la somme connexe (donc 0 dans le cas de la sphère). Comme la sphère et le tore ont comme caractéristique d’Euler-Poincaré respectivement 2 et 0, en utilisant la formule précédente sur la caractéristique d’Euler-Poincaré d’une somme connexe, nous obtenons que χ(c)=2−2g (dans le cas d’un tore, cf. exemple de la Fig. 2.5, nous avons χ=0 et g=1).

Dans le troisième cas, la surface est non-orientable. La caractéristique d’Euler-Poincaré d’un plan projectif est 1, et en utilisant la formule sur la caractéristique d’Euler-Poincaré d’une somme connexe, nous obtenons que χ(c)=2−k.

De ce fait, toute surface 2D fermée est déterminée de manière unique par sa caractéristique d’Euler-Poincaré et son orientabilité, ce qui classifie totalement les surfaces 2D fermées. Cette classification s’étend aux surfaces ouvertes en ajoutant comme caractéristique le nombre de bords. Il faut noter que ce type de classification n’existe pas en dimension supérieure dans le cas général.

Manipuler les complexes simpliciaux ou cellulaires décrits dans la section précédente revient à manipuler des ensembles et à utiliser des opérations ensemblistes. De ce fait, les algorithmes permettant de retrouver les relations entre les cellules (comme par exemple toutes les cellules adjacentes à une cellule donnée) sont coûteux car non limités aux voisinages des cellules (pour les cellules adjacentes à une cellule donnée, nous devons parcourir toutes les cellules de l’ensemble).

Pour ces raisons, plusieurs travaux se sont intéressés à la définition de structures combinatoires permettant de représenter ces modèles. Pour chaque structure, l’important est d’être capable de représenter les cellules et les relations d’adjacence et d’incidence entre ces cellules, mais également d’avoir une interprétation topologique de la structure par rapport à l’espace représenté. C’est pour cette raison que des contraintes de cohérence sont définies.

Un ensemble semi-simplicial [May67, FP90, EL94, Lan95, LL95] est un modèle algébrique représentant des simplexes et des relations d’incidence. Il est possible d’associer un ensemble semi-simplicial à tout complexe simplicial, mais le contraire n’est pas vrai. En effet, un ensemble semi-simplicial présentant des relations de multi-incidence ne pourra pas être représenté par un complexe simplicial contenant la relation de multi-incidence (cf. exemple Fig. 2.2.1). La réalisation géométrique d’un tel ensemble sera alors un CW-complexe.

La Def. 15 donne la définition des ensembles semi-simpliciaux qui, contrairement aux complexes simpliciaux, contiennent explicitement les relations de face entre les simplexes.

Les éléments de Kp sont les simplexes de dimension p (ou p-simplexes), et les applications dip sont les opérateurs de face des simplexes donnant pour chaque p-simplexe les (p−1)-simplexes de son bord. Il y a p+1 (p−1)-simplexes dans le bord d’un p-simplexe, chacun est obtenu par un dip différent, pour i allant de 0 à p. De manière générale et afin de simplifier les notations, dip est parfois noté di. Les relations djp−1(dip(s))=di−1p−1(djp(s)) garantissent la cohérence de la structure simpliciale. Par exemple, ces relations garantissent qu’un triangle est bordé par trois sommets. Intuitivement, ces relations indiquent que le simplexe obtenu par le chemin djp−1(dip) est le même que celui obtenu par le chemin di−1p−1(djp). Sans ces contraintes, un triangle pourrait avoir jusqu’à six sommets dans son bord. Il faut noter que les ensembles semi-simpliciaux sont sans opérateur de dégénérescence10 contrairement aux ensembles simpliciaux (que nous ne détaillons pas ici).

Nous pouvons voir un exemple d’ensemble semi-simplicial Fig. 2.2.1, et vérifier que les contraintes de cohérence sont satisfaites : par exemple d1(d2(1))=d1(d1(1)) et d0(d2(1))=d1(d0(1)).

[a][b]

[c]

Figure 2.7: Exemple de complexe simplicial et d’ensemble semi-simplicial. (a) Un complexe simplicial C composé de cinq 0-simplexes (étiquetés de a à e), six 1-simplexes et deux 2-simplexes. (b) Un ensemble semi-simplicial correspondant à C. Les deux 2-simplexes sont numérotés 1 et 2. (c) Un ensemble semi-simplicial qui ne correspond pas à un complexe simplicial à cause de la multi-incidence.

Le bord d’un i-simplexe s est l’ensemble des j-simplexes s′, avec 0≤ j < i, tels que s′ est une face de s. L’étoile est la relation inverse : l’étoile d’un i-simplexe s est l’ensemble des j-simplexes s′, avec i< j ≤ n, tels que s est une face de s′.

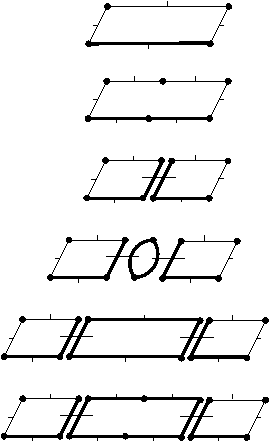

Les premiers travaux autour des cartes combinatoires [Edm60, Tut63, Jac70, Cor73, Cor75] avaient pour objectif de définir une structure de données permettant de manipuler un graphe planaire11 plongé12 sur un plan. Ces travaux ont été réalisés au sein de la communauté de la théorie des graphes dans le cadre d’études de propriétés des graphes planaires. Nous présentons ici ces travaux uniquement dans le but de donner une vision de l’historique des cartes, car ces notions sont maintenant comprises dans la définition nD des cartes combinatoires présentées Section 2.2.3.

Lorsqu’un graphe est plongé dans le plan, les arêtes peuvent être ordonnées autour des sommets et il est possible alors de définir une application donnant pour chaque arête, l’arête suivante autour d’un sommet. Mais un problème se pose : une même arête a deux successeurs différents, un pour chacun de ses deux sommets. La solution à ce problème consiste à découper chaque arête du graphe en deux éléments (appelés donc demi-arêtes ou brins). De ce fait, un brin étant incident à un seul sommet, il a un unique successeur. Par contre, il faut ajouter une relation entre les deux brins issus de la même arête. La relation donnant, pour un brin, son brin successeur autour d’un sommet a été appelée σ (s pour sommet) et celle donnant l’autre brin issu de la même arête a été appelée α (a pour arête). Comme chaque arête est représentée par deux brins, appliquer α deux fois à partir d’un brin b redonne le brin b : α est une involution. Par contre, σ est une permutation : à partir d’un brin b, appliquer σ plusieurs fois (mais pas nécessairement deux fois) permet de revenir sur b.

Une carte combinatoire 2D est donc un ensemble de brins B plus une involution α et une permutation σ, notée C=(B,α,σ). Par construction, le nombre de brins d’une carte combinatoire est le double du nombre d’arêtes du graphe. Il faut noter que les sommets du graphe ne sont pas représentés explicitement dans la carte combinatoire. En effet, un sommet est l’ensemble des brins obtenus en partant d’un brin b et en utilisant l’application σ jusqu’à retomber sur le brin de départ b.

Comme une carte combinatoire représente un graphe planaire plongé, les cycles d’arêtes délimitent des zones de l’espace appelées faces. Étant donné un brin b, la face déterminée par b s’obtient en utilisant σ ∘ α (noté ϕ, f pour face) jusqu’à retomber sur le brin de départ b. Les faces parcourues à l’aide de la permutation ϕ sont toutes parcourues avec la même orientation, mais le choix d’une orientation est arbitraire. De plus, il faut noter la présence d’une face infinie (appelée également face externe ou face englobante) qui «entoure» les autres faces.

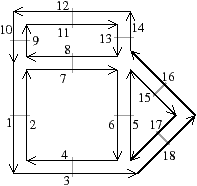

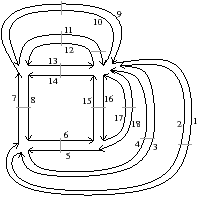

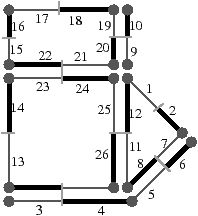

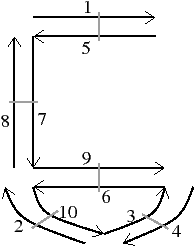

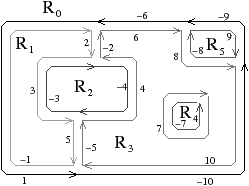

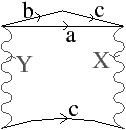

La Fig. 2.8 présente un exemple de graphe planaire (Fig. 2.2.2), et la carte combinatoire 2D correspondante qui peut être dessinée de deux manières différentes (Fig. 2.2.2 où deux brins en relation par α sont dessinés comme une arête du graphe, et Fig. 2.2.2 où deux brins en relation par α sont dessinés comme deux segments parallèle). Le sommet d du graphe correspond à l’ensemble de brins {6,8,14,15} obtenu par exemple à partir du brin 6 en utilisant l’application σ; la carte de cet exemple comporte sept sommets. La face délimitée par les sommets (c,d,f,e) du graphe correspond à l’ensemble de brins {2,4,6,7} et s’obtient par exemple à partir du brin 2 en tournant autour de la face à l’aide de ϕ : ϕ(2)=7, ϕ(7)=6, ϕ(6)=4 et ϕ(4)=2. Sur cet exemple, le choix d’orientation fait que l’intérieur de la face se trouve à droite de l’arête courante, en suivant cette arête selon son orientation. La face {1,3,10,12,14,16,18} est la face infinie. Notez que la règle d’orientation est vérifiée même pour la face infinie : l’intérieur de la face, qui se trouve à l’extérieur de l’objet, se situe bien à main droite de chaque arête de la face. Cette carte contient quatre faces : trois faces bornées et une face infinie.

[a][b]

[c]

Figure 2.8: La représentation d’un graphe planaire à l’aide d’une carte combinatoire. (a) Un graphe planaire plongé dans le plan. (b) La carte combinatoire correspondante. Les brins sont numérotés de 1 à 18. La relation σ est représentée par les flèches grises (par exemple σ(1)=7), et deux brins en relation par α sont dessinés comme un seul segment avec une barre perpendiculaire séparant les deux éléments (par exemple α(1)=2). (c) Une seconde manière de dessiner la même carte combinatoire. Un brin est représenté par une flèche, deux brins en relation par α sont dessinés parallèlement, avec des orientations opposées (par exemple α(1)=2), et reliés par un petit segment gris. Deux brins en relation par ϕ sont dessinés de manière consécutive (par exemple ϕ(1)=3). Ce type de dessin fait apparaître plus clairement les faces de la carte, alors que la première manière fait apparaître plus clairement les sommets.

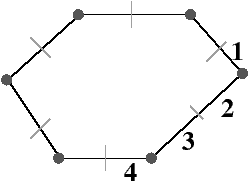

Une carte combinatoire est définie à l’aide d’une involution et une permutation, l’autre permutation étant implicite car c’est la composition des deux premières applications. Il existe deux cartes combinatoires duales l’une de l’autre selon que la permutation de la carte représente les sommets σ (comme dans le paragraphe et l’exemple précédent) ou ϕ comme dans l’exemple de la Fig. 2.9. Plus précisément, soit C=(B,α,σ) une carte combinatoire, la carte combinatoire duale est C=(B,α,ϕ). Ces cartes sont duales car les sommets de l’une correspondent aux faces de l’autre et réciproquement.

La Fig. 2.9 montre le graphe dual et la carte combinatoire duale du graphe et de la carte présentés Fig. 2.8. La carte est composée de quatre sommets et de sept faces, car la carte de la Fig. 2.2.2 est composée de sept sommets et de quatre faces. Nous pouvons vérifier sur cet exemple que σ de la carte duale égale ϕ de la carte initiale et réciproquement. Il faut faire attention à distinguer les deux représentations graphiques d’une même carte combinatoire (comme par exemple les deux cartes Fig. 2.2.2 et Fig. 2.2.2) et les deux cartes combinatoires duales (comme par exemple les deux cartes Fig. 2.2.2 et Fig. 2.2.2) qui ne sont pas les mêmes cartes.

[a][b]

[c]

Figure 2.9: Carte combinatoire duale. (a) Le multi-graphe dual (en noir) du graphe de la Fig. 2.2.2 (dessiné ici en gris). Ce multi-graphe s’obtient en mettant un sommet par face du graphe initial et en mettant autant d’arêtes entre deux sommets que le nombre de fois que les deux faces correspondantes dans le graphe initial sont voisines. (b) La carte combinatoire correspondante qui est donc la carte duale de la carte présenté Fig. 2.2.2. (c) La même carte dessinée de la seconde manière.

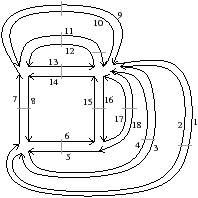

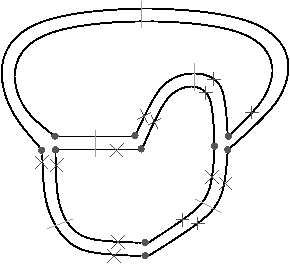

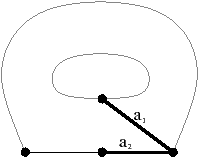

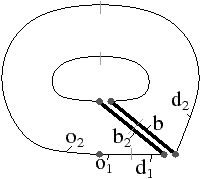

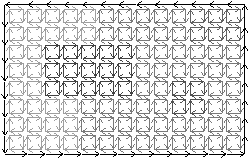

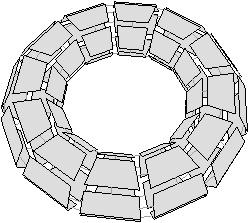

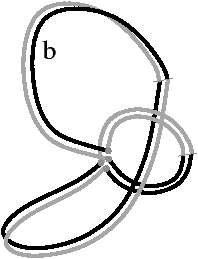

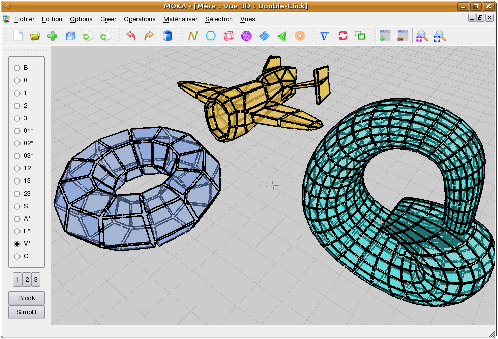

Bien que définies initialement comme une représentation des graphes planaires plongés, les cartes combinatoires 2D permettent de représenter toute subdivision de n’importe quelle surface orientable fermée. Dans le cas des graphes planaires plongés, ce sont des subdivisions de la sphère (et non du plan à cause de la face infinie). Mais une carte combinatoire 2D peut représenter une subdivision d’un tore comme sur l’exemple de la Fig. 2.2.2 ou d’un tore à deux trous comme sur l’exemple de la Fig. 2.2.2 (de manière générale, le théorème de classification des surfaces dit que toute surface orientable fermée est homéomorphe soit à une sphère soit à un tore à k trous). Étant donnée une carte combinatoire 2D, le type de la surface correspondante peut se calculer en utilisant la caractéristique d’Euler-Poincaré.

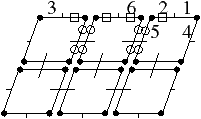

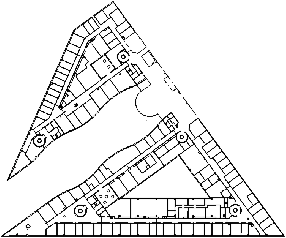

[a][b]

Figure 2.10: Deux exemples de cartes combinatoires 2D n’étant pas des subdivisions de la sphère (les nombres de cellules sont calculés par programme). (a) Une subdivision d’un tore. La carte est composée de 32 sommets, 64 arêtes et 32 faces : χ=0. (b) Une subdivision d’un tore à deux trous. La carte est composée de 82 sommets, 148 arêtes et 64 faces : χ=−2.

Enfin, une carte combinatoire 2D est équivalente à la structure des demi-arêtes [Wei85, Wei88] (en anglais half-edges) très utilisée en modélisation géométrique et en géométrie algorithmique. Il existe en effet une bijection entre les éléments de la structure en demi-arêtes (les demi-arêtes) et les éléments de la carte combinatoires 2D (les brins). Chaque demi-arête est associée avec la demi-arête suivante (ϕ dans la carte), éventuellement la demi-arête précédente (ϕ−1 dans la carte), et la demi-arête opposée (α dans la carte). Différentes implémentations des demi-arêtes ajoutent des relations liant chaque demi-arête avec le sommet incident, et/ou avec la face incidente. C’est également possible de manière équivalente pour les cartes combinatoires, et il est alors possible de formaliser les contraintes que doivent vérifier ces relations à l’aide de la notion d’orbite. Il existe plusieurs variantes de cette structure comme les arêtes ailées, les quad-edges, les DCEL…[Bau75, MP78, GS85, Män88, dBvKOS00] qui sont toutes très proches et peuvent être considérées comme des variantes du même principe original.

Les cartes combinatoires 2D ont été ensuite étendues en 3D [AK88, AK89, Lie88, Spe91] avant d’être définies de manière générique en nD [Lie89, Lie91, Lie94]. Elles permettent de représenter un complexe cellulaire orientable fermé, en décrivant les cellules du complexe ainsi que les relations d’adjacence et d’incidence entre ces cellules. Nous parlons de n-carte pour une carte combinatoire de dimension n.

Les cartes combinatoires permettent de représenter les quasi-variétés orientables fermées13. La notion de quasi-variété est introduite ici, comme une sous classe des pseudo-variétés [Elt94].

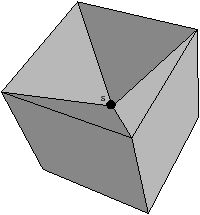

Cette notion est différente de la notion de variété topologique de dimension n classique [Ago76, Tak91] pour laquelle chaque point doit avoir un voisinage homéomorphe à une boule ouverte de dimension n (ou à une demi-boule ouverte si la variété topologique est à bord). De ce fait, une quasi-variété n’est pas forcément une variété [Lie93], excepté en dimension 2 (cf. exemple Fig. 2.11).

[a][b]

Figure 2.11: Exemple de quasi-variété qui n’est pas une variété. (b) Ce complexe cellulaire 3D est une quasi-variété car il est obtenu en collant les quatre pyramides de (a) le long de leurs faces (2-cellules). Par contre ce n’est pas une variété car le voisinage du point s n’est pas homéomorphe à la demi-boule ouverte h(B1/2)3 (c’est la demi boule qui est considérée car s est un point du bord).

Cette notion est incluse dans la notion de pseudo-variété présentée Section 2.1, mais n’est pas égale. En effet, dans la notion de quasi-variété, l’adjacence entre deux cellules de dimension n est nécessairement réalisée par une (n−1)-cellule, ce qui n’est pas le cas pour les pseudo-variétés. L’exemple de pseudo-variété donné Fig. 2.3 n’est pas une quasi-variété car il n’est possible à obtenir en collant des 2-cellules le long de 1-cellules.

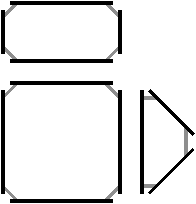

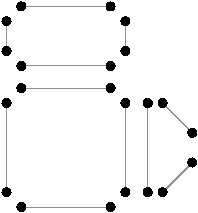

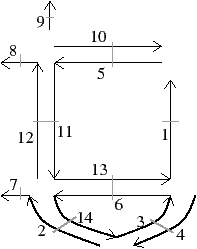

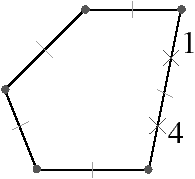

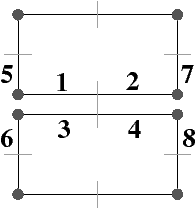

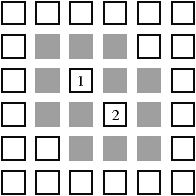

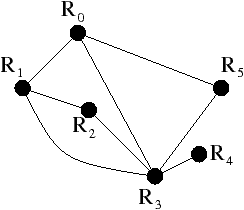

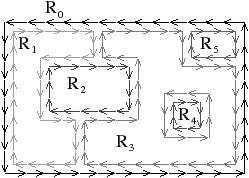

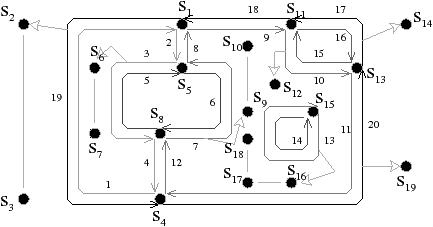

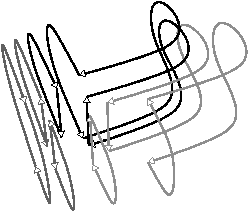

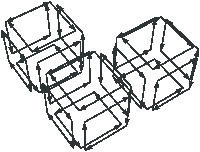

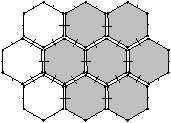

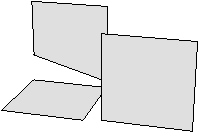

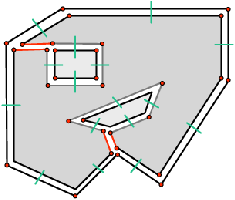

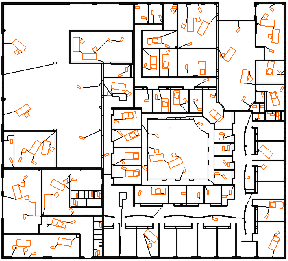

Une n-carte peut s’obtenir de manière intuitive par décompositions successives des cellules d’un objet donné, comme présenté Fig. 2.12 pour un objet 2D.

[a][b]

[c]

Figure 2.12: La décomposition d’un objet pour obtenir la carte combinatoire correspondante. (a) Un objet 2D (la face infinie n’est pas représentée). (b) Les faces de cet objet (sans la face infinie). (c) Les arêtes de ces faces.

À partir de l’objet à représenter Fig. 2.2.3, qui doit être fermé et orientable, nous commençons par distinguer les faces de cet objet Fig. 2.2.3, en conservant les relations d’adjacence entre chaque couple de faces (représentées par les traits noirs). Puis nous distinguons les arêtes de ces faces Fig. 2.2.3, en conservant les relations d’adjacence entre chaque couple d’arêtes (représentées par les traits gris).

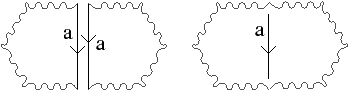

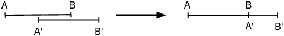

L’objet initial a été décomposé en un ensemble d’éléments, les brins, qui constituent les briques de base de la définition des cartes combinatoires. Il faut ensuite reporter les différentes relations d’adjacence sur ces éléments. La relation d’adjacence entre les arêtes est représentée par une permutation, qui pour chaque brin donne le brin suivant de la même face (en respectant une orientation donnée). Cette relation est notée β1, car elle met en relation des arêtes qui sont des cellules de dimension 1. La relation d’adjacence des faces est représentée par une involution, β2, étant donné qu’elle met en relation des cellules de dimension 2 (par rapport aux notations 2D de la section précédente, β1 correspond à ϕ et β2 à α, l’intérêt de la notation βi étant sa généralisation en dimension quelconque).

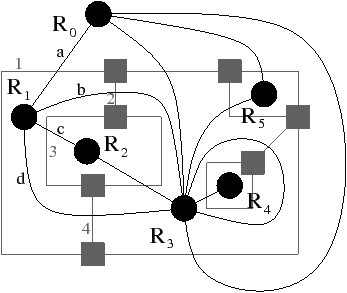

Nous pouvons voir Fig. 2.2.3 la carte combinatoire de l’objet présenté Fig. 2.2.3 ainsi que la convention graphique généralement utilisée dans les schémas de cartes combinatoires.

[a][b]

Figure 2.13: Exemple de carte combinatoire 2D et convention graphique. (a) Un objet 2D. (b) La carte combinatoire correspondante. Un brin est représenté par une flèche noire, éventuellement numéroté lorsque nécessaire. Deux brins en relation par β1 sont dessinés de manière consécutive (par exemple β1(1)=3). Deux brins en relation par β2 sont dessinés parallèles, proches et inversés, avec un petit segment perpendiculaire reliant les deux brins (par exemple β2(1)=2).

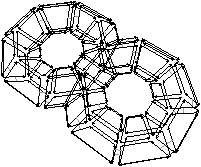

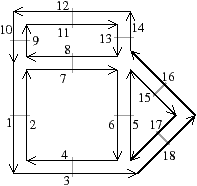

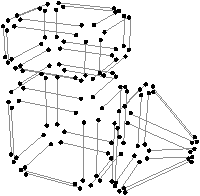

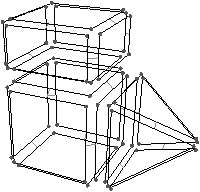

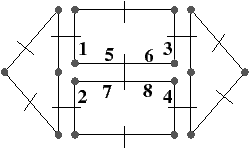

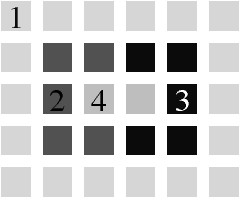

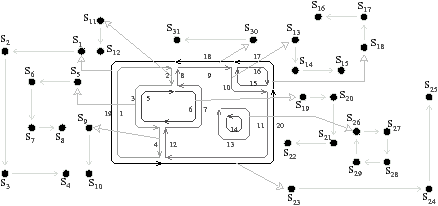

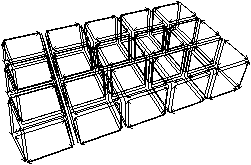

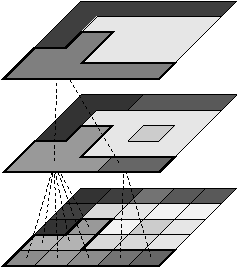

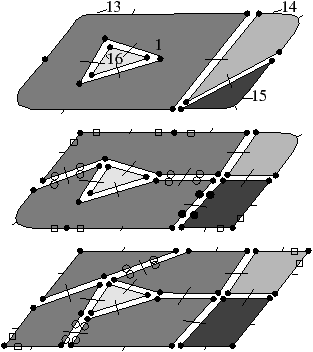

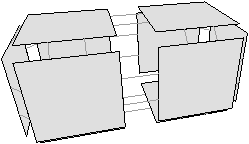

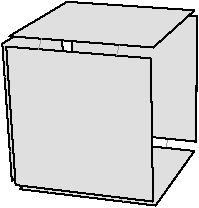

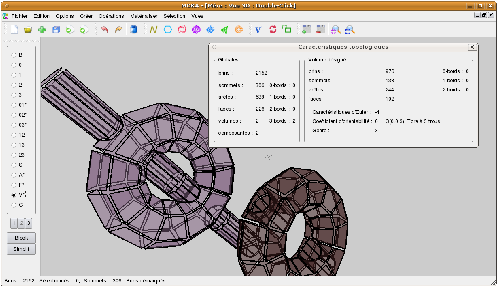

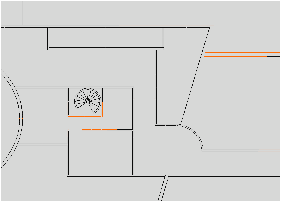

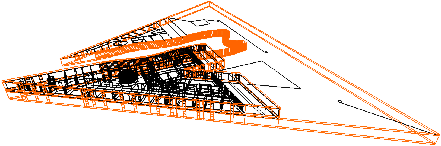

Cette méthode de décomposition d’un objet peut s’utiliser pour n’importe quelle dimension. Nous pouvons voir un second exemple de construction d’une carte combinatoire à partir d’un objet Fig. 2.14, mais cette fois pour la dimension 3.

[a][b]

[c]

[d]

Figure 2.14: La décomposition d’un objet 3D pour obtenir la carte combinatoire correspondante. (a) Un objet 3D. (b) Les volumes de cet objet. (c) Les faces de ces volumes. (d) Les arêtes de ces faces.

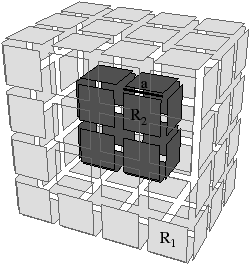

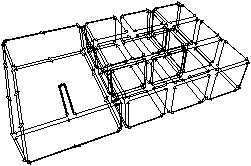

L’objet présenté Fig. 2.2.3 est décomposé successivement pour distinguer ses volumes Fig. 2.2.3, puis les faces de ces volumes Fig. 2.2.3 et enfin les arêtes de ces faces Fig. 2.2.3. Les éléments obtenus sont les brins de la carte combinatoire représentant l’objet initial. Il faut maintenant reporter les relations d’adjacence entre chaque cellule sur les brins. Il existe, comme pour la dimension 2, une permutation β1 qui met en relation un brin et le brin suivant de la même face, et une involution β2 qui met en relation deux brins de deux faces adjacentes d’un même volume. Une involution supplémentaire β3 met en relation deux volumes adjacents. La carte combinatoire obtenue est représentée Fig. 2.2.3.

[a][b]

Figure 2.15: Exemple de carte combinatoire 3D et convention graphique (représentation partielle, le volume infini n’est pas dessiné). (a) Un objet 3D. (b) La carte combinatoire correspondante. La convention graphique utilisée est la même qu’en 2D. Généralement l’involution β3 n’est pas représentée car elle peut se retrouver sans ambiguïté par la forme des faces.

Cette méthode de construction permet d’appréhender les cartes combinatoires de manière intuitive. La Def. 17 donne la définition formelle des cartes combinatoires nD ce qui nous permettra par la suite d’utiliser ses propriétés algébriques. Nous trouvons cette définition par exemple dans [Lie94].

Les brins sont ici une notion abstraite, et servent uniquement de support pour les différentes applications. Seul β1 est une permutation, les autres βi sont des involutions. La dernière ligne de cette définition pose des contraintes sur la manière dont les brins sont mis en relation pour garantir que les objets représentés sont des quasi-variétés (cette contrainte ne s’applique pas pour n<3). Par exemple, en 3D, la contrainte ajoutée est que β1∘β3 doit être une involution, ce qui revient à dire que lorsque nous mettons deux brins de deux faces différentes en relation pour β3, nous devons obligatoirement mettre tous les autres brins de ces deux faces en relation deux à deux par β3.

Nous ajoutons dans cette définition la contrainte sur βi qui doit être sans point fixe, ∀ i: 2 ≤ i ≤ n qui n’est pas présente dans [Lie94], ceci pour éviter des configurations particulières, mais ausi pour être homogène avec la définition des G-cartes (présentée section suivante).

En effet, un brin b tel que βi(b)=b, pour un i: 2 ≤ i ≤ n correspond à replier une arête sur elle même. Nous obtenons alors une configuration où une arête n’a qu’un seul sommet dans son bord. Il est alors très difficile dans ce cas de faire un lien avec une représentation cellulaire

La deuxième raison concerne le lien avec les G-cartes. En effet, pour une G-carte, un brin b point fixe pour αi est un brin considéré sans successeur (et non comme son propre successeur). Ce cas est possible pour les G-cartes car elles peuvent représenter des objets ouverts, mais n’est pas possible ici car les cartes considérées doivent être fermées.

Interdire les points fixes évite les configurations particulières, et évite le problème de différentes interprétations pour les cartes et les G-cartes. Par contre, nous conservons la possibilité pour β1 de comporter des points fixes car un brin b tel que β1(b)=b correspond au cas des boucles (c-à-d une arête incidente deux fois au même sommet) qui n’est pas une configuration particulière (dans ce type de cas, l’arête a deux sommets dans son bord même si c’est deux fois le même).

Les motivations de [Lie94] pour autoriser les points fixes pour βi étaient de pouvoir convertir n’importe quelle G-carte orientable en carte combinatoire (cf. Section 2.2.4). Nous pensons que l’ajout de contraintes sur les βi qui doivent être sans point fixe rend les choses plus simples pour les cartes combinatoires et plus homogènes, mais cela a pour inconvénient de nous obliger à restreindre légèrement la convertion de G-carte en carte.

Revenons à la définition des cartes combinatoires. Comme les cartes sont fermées, nous allons avoir, de manière similaire à la dimension 2, la présence d’une n-cellule infinie par composante connexe de la carte qui «entoure» complètement la composante et permet de représenter une quasi-variété fermée. Nous notons β0 la permutation β1−1 , et βij la composition βj∘βi. Lorsque deux brins b1 et b2 sont tels que βi(b1)=b2, nous disons que b1 est i-cousu à b2. Étant donné que les βi, pour i ≠ 1, sont des involutions, si b1 est i-cousu à b2 alors b2 est i-cousu à b1. Remarquons que chaque brin possède forcément une image pour chaque βi, étant donné que ces βi sont des bijections. L’opération consistant à mettre en relation deux brins pour βi est appelée i-couture.

Une carte combinatoire est orientée. Le choix de l’orientation est une convention qu’il faut définir, puis conserver afin que toutes les opérations soient homogènes. La carte combinatoire d’orientation inverse (cf. Def. 18) est obtenue simplement en remplaçant β1 par son inverse β0. Par exemple, la carte de la Fig. 2.2.3 est l’inverse de la carte de la Fig. 2.2.3. Il est immédiat de prouver que l’inverse d’une carte combinatoire est une carte combinatoire, ainsi que de prouver que l’inverse de l’inverse d’une carte est la carte initiale.

Une carte combinatoire ne représente pas les cellules de manière explicite, mais de manière implicite comme des ensembles de brins obtenus à l’aide de la notion d’orbite. Chaque i-cellule est une orbite particulière (cf. Def. 19). Pour simplifier les écritures, nous notons ⟨h(βi1,…,βik)⟩ pour l’orbite contenant toutes les permutations possibles sauf celles-là, c-à-d ⟨{β1,…,βn}∖{βi1,…,βik}⟩. Nous utilisons également la notation ensembliste ⟨h(I)⟩, avec I={βi1,…,βik} pour l’orbite ⟨h(βi1,…,βik)⟩. Enfin, pour simplifier les notations des orbites, nous employons indifféremment ⟨{βi1,…,βik}⟩ ou ⟨βi1,…,βik⟩ car cela n’entraîne aucune ambiguïté.

Il y a deux cas différents. L’un pour la définition des 0-cellules (les sommets), et l’autre pour les autres cellules. Cela provient du fait que β1 est une permutation alors que les autres βi sont des involutions : les cartes combinatoires n’ont pas une définition homogène (ce problème est résolu dans la définition des cartes généralisées que nous présentons Section 2.2.4).

Une i-cellule incidente à un brin b peut se voir comme l’ensemble des brins que nous pouvons atteindre par un parcours d’origine b, en utilisant les β donnés dans l’orbite ainsi que leurs inverses. Dit autrement, c’est l’ensemble des brins b′ tel qu’il existe un chemin entre b et b′ utilisant uniquement les β donnés ainsi que leurs inverses. Les 0-cellules sont définies ainsi, car nous parcourons uniquement un brin sur deux, afin de n’atteindre que les brins «sortants» du sommet incident à b. Les autres i-cellules sont simplement l’orbite composée de tous les β sauf βi. En effet, comme βi permet de changer de i-cellule, en l’enlevant de l’orbite nous restons au cours du parcours sur les brins de la même i-cellule. Remarquons enfin que chaque ensemble de i-cellules est une partition de l’ensemble des brins de la carte. Chaque brin appartient donc exactement à chaque i-cellule, ∀ i∈{0,…,n}.

Sur l’exemple de la Fig. 2.2.3, le sommet incident au brin 7 est l’ensemble des brins de l’orbite ⟨β02⟩(7)= {5,7,13,16}. L’arête incidente au brin 7 est l’ensemble des brins de l’orbite ⟨β2⟩(7)= {7,8} (dans une carte combinatoire 2D, une arête est toujours composée de deux brins, ce n’est plus vrai en dimension supérieure). Enfin, la face incidente au brin 7 est l’ensemble des brins de l’orbite ⟨β1⟩(7)= {2,4,6,7}.

C’est la définition des 0-cellules qui rend nécessaire la condition dans la définition des cartes combinatoires que les βi, pour i>1, doivent être sans point fixe. En effet, si un brin b est tel que βi(b)=b, alors β0i−1(b)=βi1=β1(b) : le brin β1(b) appartient à la même orbite sommet que celle du brin b. Cela pose problème, car le fait d’enlever un brin d’une carte va avoir pour effet de bord de fusionner des orbites sommets, alors que cette modification simple n’est pas censée modifier les sommets (ce problème est résolu Section 2.2.5 avec l’introduction des cartes ouvertes).

Avec cette définition des i-cellules, la notion d’incidence se définit simplement en étudiant l’intersection des ensembles de brins des deux cellules (cf. Def. 20).

La Def. 21 définit alors la notion d’adjacence entre deux cellules en utilisant la notion d’incidence.

Pour n’importe quel brin b, βi(b) permet de changer de i-cellule (∀ i: 1≤ i≤ n), c’est-à-dire d’obtenir un brin b′ appartenant à la i-cellule adjacente à la i-cellule contenant b le long de la (i−1)-cellule contenant b15, mais change également de 0-cellule (pour i=1, car nous allons sur l’arête suivante de la même face, et pour i, 2≤ i≤ n, car deux brins en relation par βi sont d’orientations opposées). Comme dans le cas précédent cette seconde 0-cellule peut-être égale à la première dans le cas des boucles, c-à-d une arête incidente deux fois au même sommet.

Sur l’exemple de la Fig. 2.2.3, la 1-cellule c1(7)={7,8} est incidente à la 2-cellule c2(2)={2,4,6,7}, et la 2-cellule c2(9)={8,9,11,13} est adjacente à c2(2) car elles sont toutes deux incidentes à la 1-cellule c1(7). À partir du brin 8 incident à c0(8)={2,8,10} et c2(8)={8,9,11,13}, en effectuant β2(8) nous obtenons le brin 7 incident à c0(7)={5,7,13,16} et c2(7)={2,4,6,7} : nous avons changé de 0-cellule et de 2-cellule.

La notion de chemin entre deux brins se définit simplement comme une suite de brins en liaison deux à deux par des β (cf. Def. 22). Sur l’exemple de la Fig. 2.2.3, la séquence (1,2,4,6,5,15) est un chemin obtenu à partir du brin 1 et utilisant successivement β2, β1, β1, β2, β0.

Cette notion de chemin peut servir, comme en théorie des graphes, à définir la notion de connexité (cf. Def. 23).

La Def. 24 donne une seconde définition de la connexité, équivalente à la précédente, mais qui utilise la notion d’orbite au lieu de la notion de chemin.

Il suffit de tester la propriété pour un brin b ∈ B. En effet, si pour ce brin ⟨β1,…,βn⟩(b) =B, alors tous les brins de B appartiennent à cette orbite et la propriété est donc vraie pour chaque brin de B. Par contre si la propriété n’est pas vraie pour ce brin, alors il existe au moins un brin n’appartenant pas à la même orbite que b et donc quel que soit le brin considéré, son orbite ne contiendra jamais tous les brins.

La Def. 25 définit la notion de cartes isomorphes. Intuitivement deux cartes sont isomorphes s’il existe une bijection entre leur brins respectant les relations d’adjacence.

| ∀ i ∈ {1,…,n}, ∀ b ∈ B, f(βi(b))=βi′(f(b)) |

Un automorphisme est un isomorphisme entre une carte et elle même.

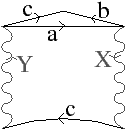

Lorsque nous considérons une subdivision d’un espace de dimension n, considérer l’espace dual revient à inverser les dimensions de l’espace de 0 à n en n à 0. De ce fait, une i-cellule dans l’espace initial va devenir une (n−i)-cellule dans l’espace dual. Cette transformation conserve les relations d’incidence et d’adjacence données dans les Def. 20 et Def. 21. Nous pouvons définir la carte combinatoire duale d’une carte donnée en gardant les mêmes brins, et en inversant l’ordre des permutations pour refléter ces changements de dimension. De plus, il faut composer les permutations βn−1, …, β1 avec βn pour obtenir une permutation (βn(n−1)) et des involutions (βni pour 1≤ i <n−1). Enfin, pour garantir que les βi, pour 2≤ i≤ n, sont sans point fixe, nous devons ajouter la contrainte que βn∘βi soit sans point fixe (ce qui revient à éviter un brin b tel que βn(b)=βi(b), ce qui un cas très particulier non utilisé dans les cas pratiques).

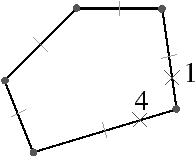

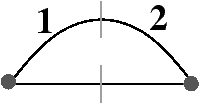

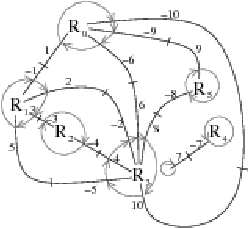

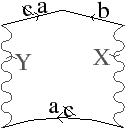

Un exemple de carte duale est donnée en 2D dans la Fig. 2.17. La 2-carte est C=(B,β1,β2) et sa carte duale C=(B,β21,β2). La Prop. 1 prouve la validité de la Def. 26 en montrant que la duale d’une carte combinatoire est une carte combinatoire.

[a][b]

Figure 2.17: Exemple de cartes combinatoires duales. (a) Une 2-carte C=(B,β1,β2), composée de 7 sommets, 9 arêtes, et 4 faces. (b) La carte duale de C, C=(B,β1′,β2′)=(B,β21,β2), composée de 4 sommets, 9 arêtes, et 7 faces. Par exemple, β1′(6)=β21(6)=15.

Nous prouvons ici les deux propriétés principales liées à la définition des cartes duales : (1) la duale d’une carte est une carte ; (2) une i-cellule incidente à b d’une carte correspond à la (n−i)-cellule incidente à b dans la carte duale. Nous devons re-prouver ces propriétés déjà évoquées dans [Lie94] à cause de la contrainte supplémentaire que nous avons ajoutée.

Proof. Pour n=1, la preuve est immédiate car C=(B,β1), donc C=(B,β1−1) est une carte combinatoire.

Pour n>1. Tout d’abord, chaque βni, pour 1≤ i≤ n−2 est bien une involution par définition des cartes. βn est également une involution (car n ≥ 2), et βn(n−1) une permutation. Le fait que les involutions sont sans point fixe se déduit directement des préconditions sur les βn∘βi qui sont sans point fixe. Les 3 premières conditions de la Def. 17 sont donc vérifiées. En notant C=(B,β1′,…,βn′), la dernière condition de la définition des cartes combinatoires s’écrit ∀ i,j: 1 ≤ i<i+2≤ j ≤ n, βi′∘βj′ est une involution.

En re-écrivant les β′ en fonction des β, cette condition se re-écrit en βn(n−i)∘βn est une involution ∀ i: 1 ≤ i ≤ n−2, et βn(n−i)∘βn(n−j) est une involution ∀ i,j: 1 ≤ i <i+2≤ j≤ n.

Commençons par la première écriture : β(n−i)∘βn∘βn=β(n−i) (car βn est une involution). Comme 1 ≤ i ≤ n−2, alors 2≤ n−i ≤ n−1, donc βn−i est une involution par définition de C et donc βn(n−i)∘βn est une involution.

Pour la seconde écriture, nous étudions βn(n−j)n(n−i), pour 1 ≤ i < i+2 ≤ j ≤ n. Comme 2<j, βn(n−j) est une involution donc égale à son inverse β(n−j)n. Donc βn(n−j)n(n−i)=β(n−j)nn(n−i)= β(n−j)(n−i). Comme i < i+2 ≤ j, β(n−j)(n−i) est une involution et donc βn(n−j)n(n−i) aussi.

La propriété principale de la dualité, énoncée dans la Prop. 2, est que toute i-cellule d’une carte devient une (n−1)-cellule dans la carte duale. Grâce à cette propriété, nous pouvons directement déduire que les relations d’incidence et d’adjacence sont identiques dans une carte et dans sa carte duale.

Proof. Par définition de la carte duale, nous avons C=(B,βn(n−1),…,βn1,βn).

Considérons tout d’abord le cas 1≤ i<n : par définition des cellules, nous avons ci(b)=⟨β1,…,βi−1,βi+1,…,βn⟩(b), et c′n−i(b)=⟨β1′,…,βn−i−1′,βn−i+1′,…,βn′⟩(b). En re-écrivant les β′, nous obtenons c′n−i(b)=⟨βn(n−1),…,βn(i+1),βn(i−1),…,βn1,βn⟩. Lorsqu’une orbite contient une fonction f∘ g et la fonction f, alors par propriété des orbites, cette orbite est équivalente à la même orbite dans laquelle nous remplaçons f∘ g par g. En effet, dans les deux cas, comme nous effectuons toutes les compositions des fonctions de l’orbite et de leurs inverses, nous obtenons le même résultat. En utilisant ce principe, c′n−i(b) peut se re-écrire en ⟨βn−1,…,βi+1,βi−1,…,β1,βn⟩, qui est donc égal à ci(b) (car l’ordre des permutations dans une orbite n’importe pas).

Considérons maintenant le cas i=0. c0(b)=⟨β02,…,β0n⟩(b), et c′n(b)=⟨β1′,…,βn−1′⟩(b). En re-écrivant les β′, nous obtenons c′n(b)=⟨βn(n−1),…, βn1⟩(b). Si n=2, alors la preuve est directe car c0(b)=⟨β02⟩, et c′2(b)=⟨β1′⟩=⟨β21⟩=⟨β02⟩. Si n>2, En utilisant la même règle que précédemment, l’orbite est identique à la même orbite dans laquelle nous composons tout les éléments sauf le dernier avec βn1. Nous obtenons l’orbite ⟨βn1n(n−1),…,βn1n2,βn1⟩(b). Comme n>2, alors βn1 est une involution donc égal à son inverse β0n. Nous pouvons donc re-écrire l’orbite en ⟨β0nn(n−1),…,β0nn2,βn1⟩(b), et donc en ⟨β0(n−1),…,β02,β0 n⟩(b), ce qui prouve que c0(b)=c′n(b).

Reste le cas i=n. cn(b)=⟨β1,…,βn−1⟩(b), et c′0(b)=⟨β02′,…,β0n′⟩(b). En re-écrivant les β′, nous obtenons c′0(b)=⟨β(n−1)nn(n−2),…,β(n−1)nn1,β(n−1)nn⟩, donc en simplifiant les βnn, nous obtenons directement ⟨β(n−1)(n−2),…,β(n−1)1,β(n−1)⟩. En combinant chaque membre sauf le dernier avec β(n−1), nous obtenons ⟨β(n−2),…,β1,β(n−1)⟩ ce qui prouve que cn(b)=c′0(b).

Nous pouvons vérifier cette propriété sur l’exemple précédent en vérifiant que chaque i-cellule de la carte de la Fig. 2.2.3 se transforme bien en une (2−i)-cellule dans la carte de la Fig. 2.2.3. Par exemple le sommet c0(10)={2,8,10} se transforme bien dans la face c′2(10) dans la carte duale, l’arête c1(10)={9,10} se transforme bien dans l’arête c′1(10) dans la carte duale, et la face c2(8)={8,9,11,13} se transforme bien dans le sommet c′0(8) dans la carte duale.

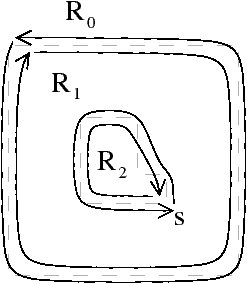

Les cartes généralisées sont une extension des cartes combinatoires permettant de représenter les quasi-variétés orientables ou non avec ou sans bord [Lie89, Lie91, Lie94]. Leur principal avantage est que leur définition est homogène à toutes les dimensions, contrairement aux cartes combinatoires, ce qui simplifie les définitions et l’écriture des algorithmes. De plus, cette homogénéité fait que la définition des cartes généralisées est directement valide pour les brins avec ou sans point fixe, car nous n’avons plus le problème qui se posait dans les cartes combinatoires lors de la définition des sommets. Ces cartes généralisées sont proches de la structure de cell-tuple [Bri89, Bri93].

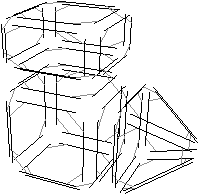

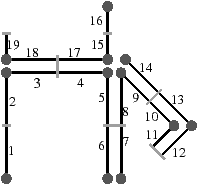

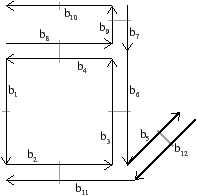

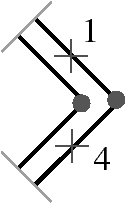

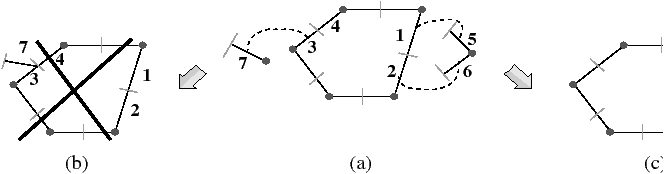

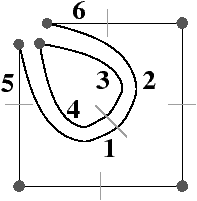

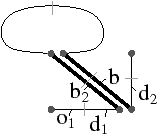

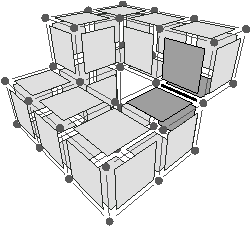

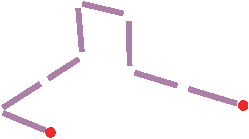

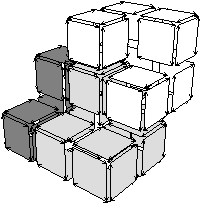

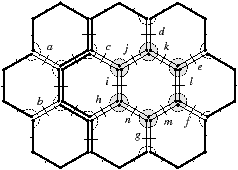

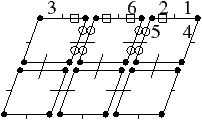

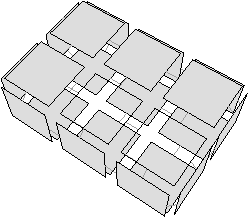

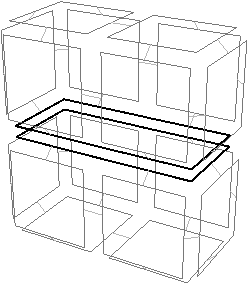

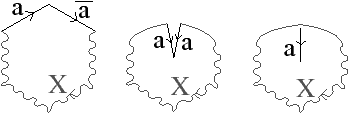

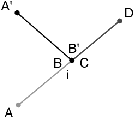

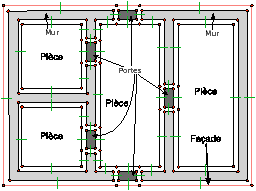

Pour définir une carte généralisée de manière intuitive, nous appliquons le même principe de décomposition que celui utilisé pour les cartes combinatoires, mais nous effectuons une décomposition supplémentaire afin de distinguer les sommets. Si nous reprenons le premier exemple utilisé pour les cartes combinatoires présenté Fig. 2.12, nous avons obtenu au final la décomposition rappelée Fig. 2.2.4.

[a][b]

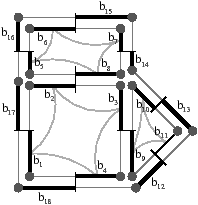

Figure 2.18: La décomposition supplémentaire d’un objet 2D pour obtenir une carte généralisée. (a) Les arêtes obtenues Fig. 2.12 après décompositions successives. (b) Les sommets de ces arêtes.

Nous décomposons ensuite les sommets, à partir de cette décomposition en arêtes et obtenons la décomposition présentée Fig. 2.2.4, où les relations d’adjacence entre les sommets d’une arête sont représentées par les segments gris. Les éléments obtenus sont les brins de la carte généralisée. Il suffit ensuite, comme pour les cartes combinatoires, de reporter les relations d’adjacence sur ces brins pour obtenir la carte généralisée présentée Fig. 2.2.4.

[a][b]

[c]

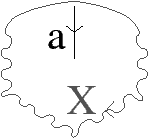

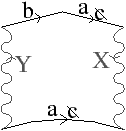

Figure 2.19: Exemple de carte généralisée 2D et convention graphique. (a) La carte combinatoire de la Fig. 2.13. (b) La carte généralisée représentant le même objet. Un brin est représenté par un segment avec un disque à une extrémité et un petit segment perpendiculaire à l’autre extrémité. Deux brins reliés par α0 sont dessinés de manière consécutive, alignés, et partagent le même petit segment perpendiculaire (par exemple α0(1)=2). Deux brins reliés par α1 partagent le même disque (par exemple α1(1)=6). Deux brins reliés par α2 sont dessinés de manière parallèle et partagent le même petit segment perpendiculaire (par exemple α2(1)=4). (c) Une 2G-carte ouverte (0-ouverte, 1-ouverte et 2-ouverte). Les brins 11, 12 et 19 sont 0-libres, les brins 1, 6, 7, 14 et 16 sont 1-libres et les brins 1, 2, 15, 16 et 19 sont 2-libres.

Étant donné que nous avons également séparé les sommets pour les cartes généralisées, nous n’avons plus besoin, comme pour les cartes combinatoires, d’utiliser une permutation pour parcourir les faces. En effet, chaque «côté» d’une arête sera lié avec l’arête suivante de la face pour ce sommet. Il existe donc une involution α0 qui met en relation les deux brins de la même face et de la même arête, une involution α1 qui met en relation les deux brins de la même face et du même sommet, et une involution α2 qui met en relation les deux brins de la même arête et du même sommet.

Comme pour les cartes combinatoires, nous ne représentons pas de manière explicite toutes les involutions et utilisons la représentation intuitive présentée Fig. 2.2.4. Deux brins cousus par α0 sont représentés par un seul segment portant un petit segment perpendiculaire en son milieu, deux brins cousus par α1 sont représentés de manière contiguë séparés par un disque, et deux brins cousus par α2 sont représentés parallèles et proches, avec la barre représentant α0 traversant les deux segments.

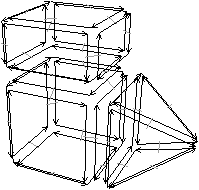

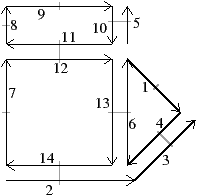

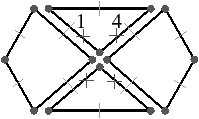

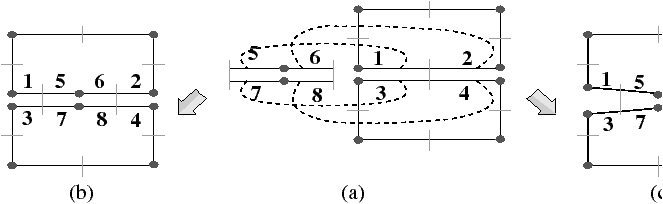

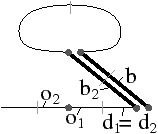

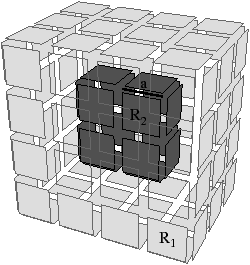

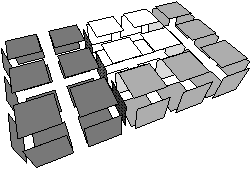

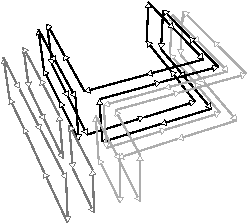

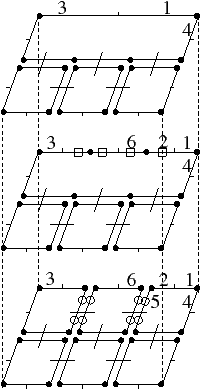

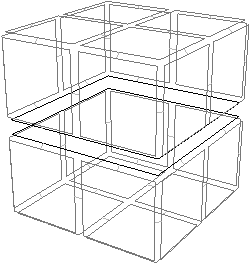

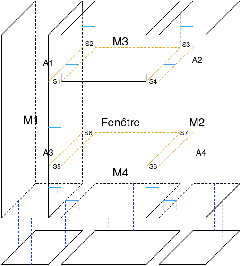

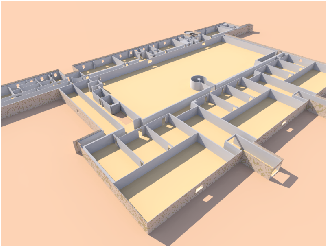

Nous pouvons voir Fig. 2.20 le même principe appliqué en dimension 3 à notre exemple de la Fig. 2.14. Pour les cartes combinatoires, nous avons obtenu au final la décomposition en arêtes rappelée Fig. 2.2.4.

[a][b]

Figure 2.20: La décomposition supplémentaire d’un objet 3D pour obtenir la carte généralisée correspondante. (a) Les arêtes obtenues Fig. 2.14 après décompositions successives. (b) Les sommets de ces arêtes.

La décomposition en sommets des arêtes de cette figure est présentée Fig. 2.2.4, et la carte généralisée correspondante Fig. 2.2.4.

[a][b]

Figure 2.21: Exemple de carte généralisée 3D et convention graphique. (a) La carte combinatoire de la Fig. 2.15. (b) La carte généralisée représentant le même objet. La convention graphique utilisée est la même qu’en 2D. Généralement α3 n’est pas représenté car il peut se retrouver sans ambiguïté par la forme des faces.

La Def. 27 [Lie91] donne la définition des cartes généralisées en dimension n :

En comparaison avec les cartes combinatoires, il existe une involution supplémentaire, et il n’y a plus de différence entre les α qui sont tous des involutions. De plus, ces involutions peuvent maintenant toutes être avec ou sans point fixe sans que cela change la définition ni que cela pose de problème pour la définition des cellules. Les nG-cartes sont définies à partir de n=−1, afin de pouvoir définir la G-carte vide, composée uniquement d’un ensemble de brins sans aucune involution. Nous parlons de brin i-libre pour un brin b point fixe pour αi (c-à-d tel que αi(b)=b). C’est un brin n’ayant pas d’autre brin en relation par αi, et qui est alors considéré comme n’ayant pas de successeur pour αi et non pas comme étant son propre successeur. De manière similaire à la notation βij, nous notons αij=αj ∘ αj.

Nous disons qu’une G-carte est i-fermée si aucun de ses brins n’est i-libre. Une carte n’étant pas i-fermée est dite i-ouverte. Enfin, nous parlons de G-carte fermée pour une G-carte i-fermée pour toutes les dimensions de l’espace, et de G-carte ouverte sinon (par exemple la 2G-carte de la Fig. 2.2.4 est fermée, et celle de la Fig. 2.2.4 est ouverte).

Les G-cartes sont totalement homogènes, ce qui simplifie les définitions et les algorithmes comme nous pouvons le voir, par exemple, pour la Def. 28 des cellules. Comme pour les cartes combinatoires, nous utilisons la notation ⟨h(αi1,…,αik)⟩ pour l’orbite contenant toutes les involutions possibles sauf celles-là, c-à-d ⟨{α0,…,αn}∖{αi1,…,αik}⟩, ainsi que la notation ensembliste ⟨h(I)⟩, avec I={αi1,…,αik}, pour l’orbite ⟨h(αi1,…,αik)⟩.

Cette définition de cellule est maintenant homogène pour toutes les dimensions i∈{0,…,n} : il n’est plus nécessaire de distinguer les sommets des autres cellules. De ce fait, le cas des points fixes ne pose plus de problème car la définition des cellules n’utilise jamais la composition de deux involutions, ce qui était la raison du problème pour la définition des sommets comme nous l’avons vu dans la section précédente.

Les définitions d’incidence et d’adjacence données pour les cartes combinatoires (Defs. 20 et 21) sont toujours valides pour les G-cartes car elles se basent sur la notion de cellule, notion que nous venons de redéfinir pour les G-cartes. Les Defs. 22 et 25 de chemin et d’isomorphisme sont identiques pour les G-cartes, sous réserve de remplacer βi par αi, la Def. 23 de connexité est toujours valide car elle utilise la notion de chemin, tandis que pour la seconde définition de connexité (Def. 24), il faut remplacer l’orbite utilisée par ⟨α0,…,αn⟩(b)=B.

Mais pour représenter des quasi-variétés orientables, les G-cartes sont deux fois plus coûteuses en espace mémoire que les cartes combinatoires. Ce surcoût en mémoire peut être prohibitif, et c’est pour cette raison que selon les applications, nous utilisons les cartes combinatoires ou les cartes généralisées, pour privilégier la généricité des opérations ou l’espace mémoire.

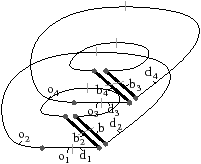

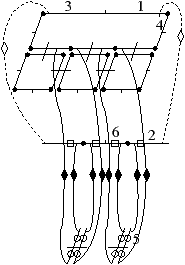

En effet, lorsque nous travaillons avec des G-cartes orientables, les deux modèles sont équivalents : nous savons effectuer facilement la transformation permettant de passer aux cartes combinatoires, et lorsque nous travaillons avec une carte combinatoire, nous pouvons définir sans problème la carte généralisée correspondante. Afin de réaliser cette conversion, nous devons être en mesure de savoir si une G-carte est orientable ou non. C’est l’objet de la Def. 29 donnée initialement dans [Lie94], mais que nous modifions ici pour se restreindre aux nG-cartes sans point fixe pour αi∘α0, ∀ i: 2≤ i≤ n.

Nous ajoutons la contrainte sur l’absence de point fixe pour αi∘α0, ∀ i: 2≤ i≤ n, pour garantir que HG soit une carte combinatoire valide au sens de notre Def. 17, c’est à dire sans point fixe pour βi, ∀ i: 2≤ i≤ n. Cette contrainte n’était pas présente dans la définition de [Lie94] car l’auteur utilisait la définition étendue des cartes combinatoires ayant éventuellement des points fixes (il faut également noter que, dans ce même article, la définition à été étendue aux G-cartes pouvant avoir des points fixes pour αn). Cette restriction n’est pas limitante car elle interdit uniquement des configurations très particulières dans lesquelles un brin b est lié avec b′ à la fois par α0 et par un autre αi. De ce fait, nous avons une arête repliée auquel il est très difficile d’associer un sens dans le complexe cellulaire correspondant.

Cette définition permet facilement de tester, étant donné une G-carte, si elle est orientable ou non. De manière intuitive, une G-carte orientable contient les deux orientations possibles de la carte combinatoire correspondante (cf. l’exemple de la Fig. 2.2.4)). Cette définition est valable uniquement pour les G-cartes fermées connexes pour la même raison qui pose problème lors de la définition des sommets dans les cartes combinatoires ouvertes. En effet, nous composons ici deux involutions αi∘α0, ce qui va poser problème par exemple si α0 a un point fixe b car nous allons alors avoir α0i(b)=αi(b) (cf. l’exemple de la Fig. 2.2.4). Par contre, cette définition s’étend directement aux G-cartes fermées non connexes : une nG-carte fermée est orientable si chaque composante connexe est orientable.

[a][b]